Nvidia Ampère

Plus tôt dans la journée, Nvidia a finalement annoncé la prise en charge des processeurs avec l'architecture ARM ainsi que toute sa pile de logiciels d'IA et de HPC. Nvidia connaît bien ARM car ils ont intégré l'architecture dans leurs puces Tegra et autres produits système sur puce pour les jeux portables, les véhicules autonomes, la robotique et l'informatique embarquée AI.

Pourquoi maintenant?

ARM existe depuis un certain temps, mais son utilisation dans les systèmes HPC est inexistante depuis quelques années. Presque tous les systèmes HPC utilisent des puces d'Intel, car elles existent depuis longtemps, ce qui se traduit par une excellente prise en charge des logiciels et des bibliothèques hérités.

Au fil des ans, ARM a travaillé sans relâche pour construire un écosystème qui peut faire de son architecture une alternative viable aux puces x86. Le projet du Mont-Blanc a été une grande initiative dans ce sens.

Les partenaires du Mont-Blanc ont dû partir de zéro pour construire des systèmes de test Arm HPC basés sur la technologie de téléphonie mobile 32 bits et des logiciels et outils de portage et de réglage pour créer un écosystème logiciel Arm. En 2015, Mont-Blanc a déployé le premier cluster HPC basé sur Arm au monde, comprenant plus de 2 000 processeurs mobiles. Ce système a permis de démontrer la viabilité de l'utilisation de la technologie Arm pour le HPC.

- OAG

Ces initiatives portent enfin leurs fruits et puces avec l'architecture ARM qui est de plus en plus utilisée dans divers systèmes HPC à travers le monde.

Intérêts commerciaux de Nvidia dans les centres de données

Nvidia domine déjà une grande partie de l'activité GPU grand public et au fil des ans, ils ont créé une pile matérielle et logicielle respectable pour les stations de travail. Du côté logiciel, ils ont de nombreuses solutions concernant les charges de travail IA et Deep Learning. Toutes ces charges de travail peuvent être accélérées par les GPU et c'est là que leurs GPU Tesla et Volta entrent en jeu.

Cela a aidé les finances de l’entreprise et, selon un article sur Fobes rédigé par Karl Freund ' Au premier trimestre 2019 de NVIDIA, la société a une fois de plus dépassé les attentes, rapportant une croissance de 66% de son chiffre d'affaires total, y compris une croissance de 71% de son activité de centres de données brûlante (atteignant 701 millions de dollars pour le trimestre). Pour NVIDIA, le segment «Datacenter» comprend le calcul haute performance (HPC), les graphiques hébergés dans le centre de données et l'accélération de l'IA. »

Ce sont également de grands points de discussion dans les keynotes des investisseurs de Nvidia. Après l'acquisition de Mellanox par Nvidia dont nous avons couvert ici , Le PDG Jensen Huang a partagé un aperçu de la décision en déclarant « La stratégie est en train de doubler sur les centres de données, et nous combinons et unissons deux leaders des technologies de calcul haute performance. Nous nous concentrons sur le calcul accéléré pour le calcul haute performance, et Mellanox se concentre sur la mise en réseau et le stockage pour le calcul haute performance, et nous avons réuni les deux sociétés sous un même toit. Notre vision est que les centres de données sont les ordinateurs les plus importants au monde aujourd'hui, et qu'à l'avenir, alors que les charges de travail continuent d'évoluer - ce qui est vraiment déclenché par l'intelligence artificielle et l'analyse de données - que les futurs centres de données de toutes sortes seront construits comme de hautes performances. des ordinateurs. Les centres de données hyperscale ont vraiment été créés pour fournir des services et une informatique légère à des milliards de personnes. Mais au cours des dernières années, l'émergence de l'intelligence artificielle et de l'apprentissage automatique et de l'analyse de données a mis tellement de charge sur les centres de données, et la raison en est que la taille des données et la taille des calculs sont si grandes qu'elles ne correspondent pas à un seul. ordinateur. Il doit donc être distribué sur plusieurs ordinateurs et la connectivité haute performance permettant à ces ordinateurs de fonctionner ensemble devient de plus en plus importante. C'est pourquoi Mellanox a si bien grandi et pourquoi les gens parlent de SmartNIC, de tissus intelligents et de réseaux définis par logiciel. Toutes ces conversations mènent au même endroit, et c'est un avenir où le centre de données est un moteur de calcul géant qui sera cohérent - et il permettra à de nombreuses personnes de le partager encore - mais permettra à peu de personnes d'exécuter de très grandes applications. sur eux aussi. Nous pensons que dans le futur des centres de données, le calcul ne commencera pas et ne se terminera pas au niveau du serveur, mais s'étendra au réseau et le réseau lui-même fera partie de la structure informatique. Sur le long terme, je pense que nous avons la capacité de créer des architectures informatiques à l'échelle du datacenter. '

ARM prêt pour le succès

Les puces ARM alimentent la plupart des appareils mobiles dans le monde, de sorte que l'architecture reste économe en énergie de par sa conception. Étant donné que l'architecture est sous licence, avec ARM, plusieurs fabricants de silicium peuvent être envisagés.

La consommation d'énergie reste une grande préoccupation avec les HPC et l'utilisation d'ARM peut compenser ce problème dans une large mesure. Même avec le logiciel, avec les projets du Mont-Blanc, de nombreuses bibliothèques et outils scientifiques ont été développés pour ARM, cela joue un grand rôle dans la progression de tout l'écosystème.

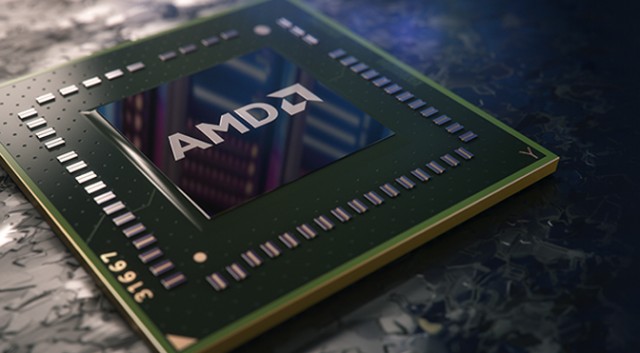

L'utilisation d'ARM dans les HPC et les centres de données est encore faible par rapport aux systèmes x86, mais Nvidia voit le potentiel ici. Leur rival AMD a également commencé à rivaliser férocement sur le marché du HPC et des centres de données avec ses processeurs de serveur EPYC et ses accélérateurs GPU Radeon Instinct. Il est donc important pour Nvidia d’adopter maintenant ARM et de proposer sa suite logicielle (CUDA-X HPC, ect). Contrairement à certains fabricants, Nvidia ne fabrique pas de processeurs, ils n'ont donc pas la cohérence CPU-GPU qu'AMD et Intel peuvent offrir.

Avec le recul, Nvidia peut renforcer un partenariat avec ARM, car NextPlatform déclarer à juste titre ' Nvidia et Arm pourraient conclure un partenariat pour rendre les blocs IP NVLink disponibles à ceux qui achètent des licences Neoverse, permettant un couplage plus étroit avec les GPU, y compris les atomiques de mémoire et la cohérence de la mémoire à travers les complexes de calcul CPU-GPU. '

Cette décision aidera certainement le cas d'ARM en tant qu'alternative d'architecture viable aux HPC x86. Nous pouvons nous attendre à une évolution similaire de la part d'AMD dans le futur, car ils continuent de pousser agressivement leurs GPU Radeon Instinct.

Mots clés BRAS nvidia

![[FIX] Code d'erreur de restauration du système 'STATUS_WAIT_2'](https://jf-balio.pt/img/how-tos/08/system-restore-status_wait_2-error-code.png)