Nvidia

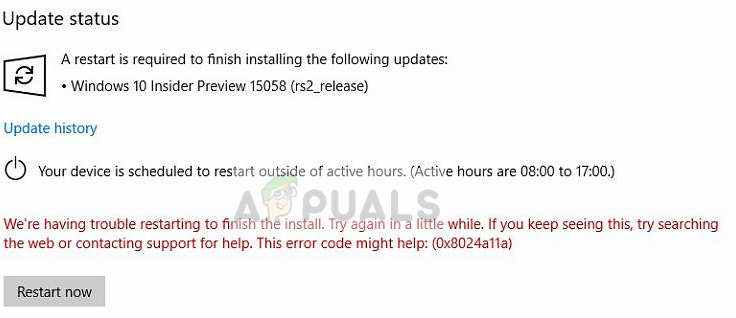

NVIDIA a officiellement lancé le A100, un GPU compatible PCIe 4.0 basé sur l'architecture Ampere de nouvelle génération. Bien que présentant un profil TDP inférieur de 250 W, NVIDIA promet que le GPU PCIe 4.0 Ampère A100 sera en mesure d'offrir jusqu'à 90% des performances du GPU A100 HGX 400 W complet. Troisième variante de sa famille grandissante de GPU Ampere A100, l'A100 PCIe est destinée aux serveurs exécutant des clusters d'intelligence artificielle (IA), de science des données et de superinformatique.

NVIDIA a révélé une variante PCI-Express 4.0 du GPU A100. Le GPU est basé sur la microarchitecture 7 nm Ampère. En outre, la société a également annoncé plusieurs systèmes alimentés par A100 de grands fabricants de serveurs, notamment Asus, Dell, Cisco, Lenovo, etc. L'accélérateur GPU 250W A100 PCIe 4.0 est assez similaire à la variante TDP complète de 400W, et NVIDIA promet également des performances presque identiques malgré la baisse significative du profil TDP.

GPU NVIDIA A100 Ampère au facteur de forme PCIe 4.0 avec la même configuration de GPU 400W A100 HGX mais à 250W:

NVIDIA a annoncé son accélérateur GPU PCIe 4.0 A100 PCIe. Le GPU Ampere est disponible pour un ensemble diversifié de cas d'utilisation industrielle avec des systèmes allant d'un seul GPU PCIe A100 aux serveurs utilisant deux cartes en même temps via les 12 canaux NVLINK qui fournissent un total de 600 Go / s de bande passante d'interconnexion. L'accélérateur GPU 250W TDP A100 PCIe ne change pas beaucoup en termes de configuration de base par rapport au GPU 400W A100 HGX.

Cette année à ISC Digital, @nvidia fait des annonces autour de son A100 #GPU , et un nouveau #AI plateforme pour #supercalcul , #NVIDIA Plateforme Mellanox UFM Cyber-AI. Retrouvez les détails ici! ☺️ #TechNews @NVIDIADC @NVIDIAAI @mellanoxtech #AI #Lundi matin https://t.co/YXrFGlTYJ0

- StorageReview.com (@storagereview) 22 juin 2020

Le GPU GA100 a les spécifications de la variante 400W A100 HGX avec 6912 cœurs CUDA organisés en 108 unités SM, 432 cœurs Tensor et 40 Go de mémoire HBM2 qui fournit la même bande passante mémoire de 1,55 To / s (arrondie à 1,6 To / s). Cependant, le déploiement du package GPU sur le Norme PCIe 4.0 avait son propre inconvénient de réduire considérablement le TDP. Cela signifierait une pénalité de 10 à 50% sur les performances en fonction de la charge de travail. De plus, la variante TDP 250 W du GPU A100 est plus adaptée aux rafales courtes qu'aux charges soutenues.

GPU NVIDIA A100 Ampère dans les performances du facteur de forme PCIe 4.0:

En raison de la réduction significative du profil TDP, on pourrait supposer que la carte comporterait des horloges plus basses pour compenser la moindre entrée de TDP. Cependant, les mesures de performance publiées par NVIDIA sont vraiment surprenantes car elles se rapprochent assez de la variante TDP 400W. La performance FP64 est toujours évaluée à 9,7 / 19,5 TFLOP, la performance FP32 est évaluée à 19,5 / 156/312 TFLOP (Sparsity), la performance FP16 est évaluée à 312/624 TFLOP (Sparsity) et INT8 est évaluée à 624/1248 TOP ( Parcimonie).

[PR] GIGABYTE présente une large gamme de serveurs de la série G alimentés par NVIDIA A100 PCIe https://t.co/Jxjrjzpl0F pic.twitter.com/Lr5KNvhx09

- TechPowerUp (@TechPowerUp) 22 juin 2020

Des calculs simples indiquent, et NVIDIA l'assure, que le GPU PCIe 4.0 250 W A100 basé sur Ampère peut fournir 90% des performances de la carte A100 HGX (400 W) dans les principales applications serveur. Cela se justifie car il faut moins de temps pour que la nouvelle variante accomplisse les tâches susmentionnées. Cependant, les chiffres ne doivent être valables que pour de courts intervalles. Dans les situations complexes nécessitant des capacités GPU soutenues, le GPU 250 W PCIe 4.0 peut offrir de 90% à 50% des performances du GPU A100 HGX 400 W.

Supermicro élargit son portefeuille de systèmes GPU de pointe avec une prise en charge complète du nouveau @NVIDIA GPU A100 PCI-E sur plus d'une douzaine de systèmes.

Apprendre encore plus: https://t.co/K8g41s7sKv #NVIDIA #Supermicro # A100 #AI #HPC #GPU @NVIDIADC pic.twitter.com/9og6gfdrlw

- Supermicro (@Supermicro_SMCI) 22 juin 2020

La microarchitecture Ampère profitera sûrement au nouveau A100. NVIDIA promet au moins une augmentation des performances de 20 fois par rapport au prédécesseur basé sur Volta. Le GPU PCIe 4.0 A100 est doté de la technologie GPU multi-instance. Cela signifie qu'un seul A100 peut être partitionné en sept GPU distincts pour gérer différentes tâches informatiques. Bien que cela renforce la segmentation, il existe un NVLink de 3e génération, qui permet à plusieurs GPU d'être réunis en un seul GPU géant.

Mots clés nvidia

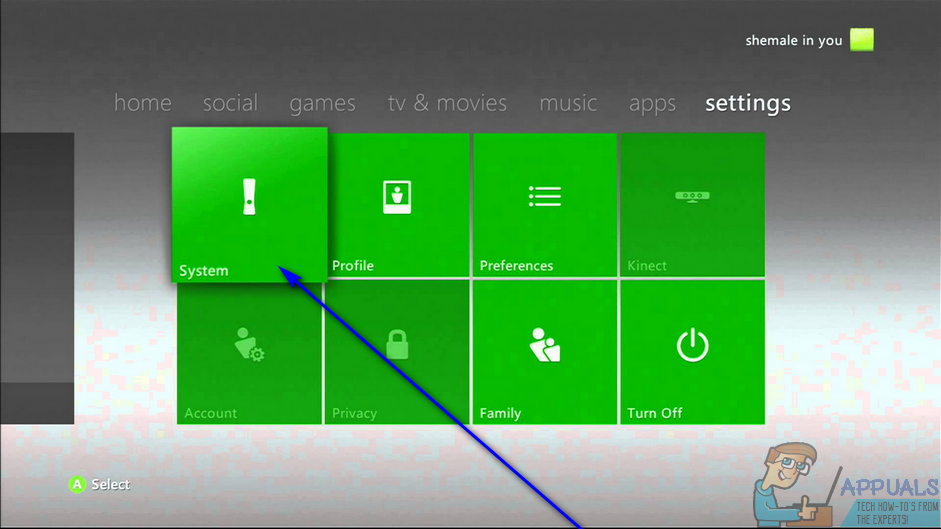

![[FIX] Erreur système de démarrage Xbox One E105](https://jf-balio.pt/img/how-tos/66/xbox-one-startup-system-error-e105.png)